- Los centros de datos de IA de 2036 no estarán dominados por GPUs.

- FuriosaAI apuesta por chips especializados y eficiencia energética para el futuro de la IA.

- La arquitectura de FuriosaAI busca optimizar modelos sin depender de estructuras heredadas de las GPUs.

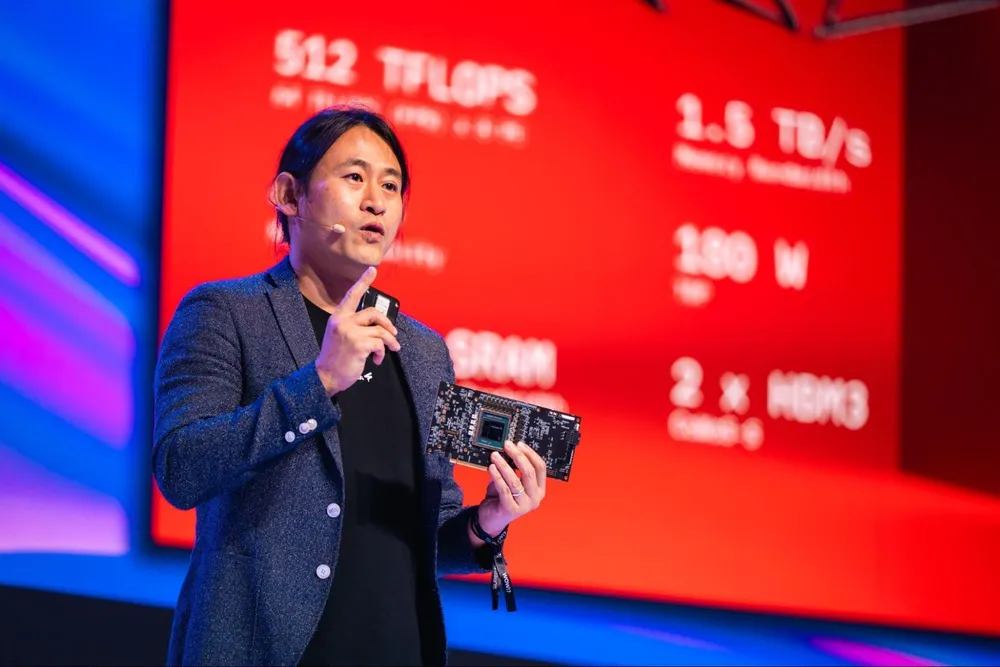

La inteligencia artificial (IA) está impulsando una demanda sin precedentes de hardware especializado, lo que ha llevado a un aumento en los costes y la complejidad de la infraestructura. Empresas emergentes como FuriosaAI están intentando cambiar este paradigma, enfocándose en la eficiencia, el rendimiento y enfoques alternativos al mercado dominado por las GPUs. Fundada en Corea del Sur, FuriosaAI desarrolla chips de inferencia de IA diseñados para ofrecer un alto rendimiento mientras reducen el consumo de energía y la tensión en los centros de datos. Su último procesador, RNGD, se basa en la arquitectura Tensor Contraction Processor de la compañía y tiene como objetivo ejecutar modelos de IA exigentes sin depender de los marcos de GPU tradicionales. June Paik, CEO y cofundador de FuriosaAI, cree que el futuro de la IA reside en la especialización del silicio.

El desafío de la IA y la competencia en el silicio

La rápida evolución de la IA presenta un desafío único para los fabricantes de hardware. A diferencia de la minería de criptomonedas, donde los algoritmos son fijos, la IA avanza constantemente, lo que requiere una combinación de experiencia en hardware y compiladores. Este tipo de conocimiento tiende a concentrarse en regiones con una sólida herencia en semiconductores y relaciones profundas con fábricas y socios de fabricación. La ubicación de FuriosaAI en Corea del Sur ha sido una ventaja, proporcionando acceso a talento de primer nivel y asociaciones clave, como con SK Hynix para la memoria HBM3 y TSMC como socio de fundición. La compañía se ha centrado en su enfoque basado en la contracción tensorial, ignorando la sabiduría convencional y el bombo del Valle.

Competencia frente a la hegemonía de Nvidia

Replicar la extensa biblioteca CUDA de Nvidia se considera una estrategia sin futuro. FuriosaAI ha adoptado un enfoque audaz al co-diseñar su hardware y software desde cero, específicamente para IA. Sus chips utilizan la arquitectura propietaria Tensor Contraction Processor (TCP), que ejecuta de forma nativa las matemáticas multidimensionales del aprendizaje profundo. Esto permite que su compilador optimice modelos sin necesidad de miles de kernels ajustados manualmente. El chip RNGD, ahora en producción masiva, demuestra estas ventajas, ofreciendo una inferencia de alto rendimiento con un consumo de energía significativamente menor en comparación con las GPUs. La empresa ha roto el bloqueo de CUDA integrando su pila de software con herramientas estándar como PyTorch y vLLM.

El futuro heterogéneo de los centros de datos de IA

El paradigma actual de las GPUs está generando desafíos energéticos extremos y cuellos de botella en la infraestructura. FuriosaAI prevé un futuro definido por la computación heterogénea, donde diferentes arquitecturas colaboran para satisfacer diversas necesidades, como el entrenamiento y la inferencia. La tecnología de la compañía, que prioriza el coste total de propiedad (TCO), la eficiencia energética y la flexibilidad, jugará un papel central en la resolución de estos problemas. La empresa se enfoca actualmente en cuatro sectores clave que experimentan estas dificultades de manera aguda: industrias reguladas y naciones que necesitan trabajar con datos sensibles localmente, clientes empresariales que buscan TCO y flexibilidad, nubes regionales y especializadas que compiten con los grandes proveedores, y sectores como las telecomunicaciones con entornos de centros de datos con restricciones de energía en el borde de la red. El próximo chip de próxima generación de FuriosaAI apuntará directamente a los hiperescaladores.

Visión de los centros de datos en 2036

En 2036, el término "centro de datos" abarcará una amplia gama de configuraciones, desde instalaciones enormes y posiblemente alimentadas por fusión hasta centros pequeños e hipereficientes. Se espera que hospitales locales y empresas de telecomunicaciones cuenten con centros de datos de IA locales para mantener la baja latencia y la seguridad de los datos. Una predicción clave es que los centros de datos de IA de 2036 no estarán llenos de GPUs, sino que albergarán una variedad de silicios específicos para IA adaptados a diferentes necesidades. Esto se debe en parte a la ineficiencia energética de las GPUs, un tema que también abordamos en nuestro artículo sobre el aumento de los precios de las GPUs de gama alta debido a la IA, y al reconocimiento general de que su arquitectura no es ideal para la IA, a pesar de las innovaciones como los núcleos tensoriales. Los beneficios de pasar a arquitecturas centradas en la IA serán demasiado grandes para ignorarlos. El problema del consumo energético es también agravado por el consumo de agua de los centros de datos de IA, un problema que merece una atención especial.

Hoja de ruta de FuriosaAI: Más allá de las GPUs

La hoja de ruta de FuriosaAI se centra en ofrecer a los clientes empresariales lo que más necesitan: inferencia de alto rendimiento en centros de datos que sea eficiente en energía, rentable y fácil de implementar sin grandes actualizaciones de infraestructura. Esto implica priorizar métricas como tokens por vatio y tokens por rack para una mayor densidad de cómputo. La empresa aprovechará activamente los avances de la industria, como nodos más pequeños y nuevas tecnologías de memoria. Si bien la arquitectura es clave, FuriosaAI también pone un gran énfasis en el software, empleando más ingenieros de software que de hardware para admitir rápidamente nuevos modelos y herramientas de implementación. Se espera que la compañía mantenga un ritmo constante de actualizaciones de SDK en los próximos años.