- Cuatro hombres robaron joyas por valor de 88 millones de euros del Louvre en menos de ocho minutos.

- Los ladrones se disfrazaron de trabajadores de la construcción, utilizando la psicología de la "normalidad" para evitar sospechas.

- Este método de categorización social, que hace que lo ordinario pase desapercibido, es similar a cómo funcionan muchos sistemas de IA, haciéndolos vulnerables.

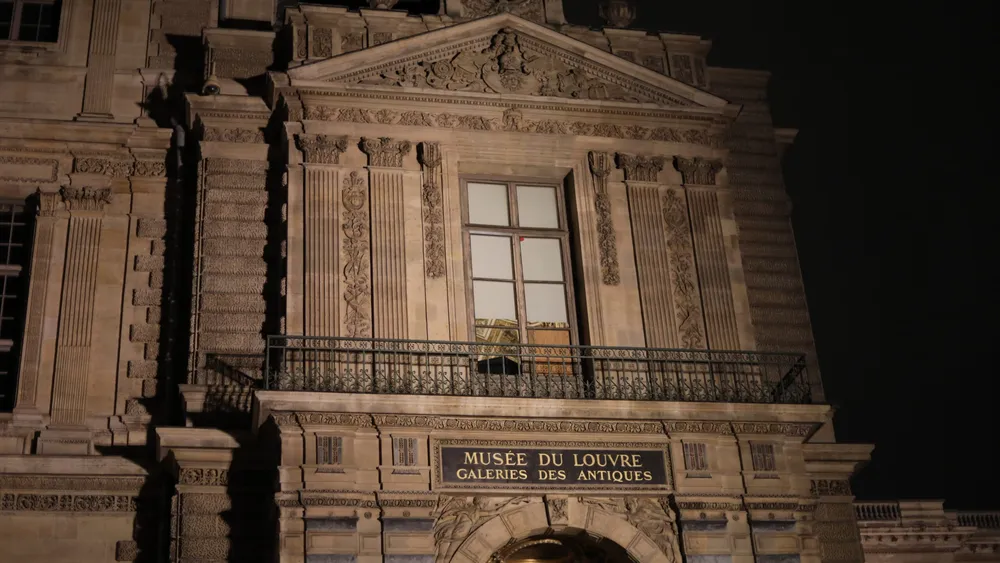

El 19 de octubre de 2025, cuatro individuos presuntamente entraron en el museo más visitado del mundo y salieron minutos después con joyas de la corona valoradas en 88 millones de euros. El robo en el Museo del Louvre de París, una de las instituciones culturales con mayor vigilancia del planeta, duró menos de ocho minutos. Los visitantes continuaron su recorrido, la seguridad no reaccionó hasta que se activaron las alarmas, y los hombres desaparecieron en el tráfico de la ciudad antes de que nadie se diera cuenta de lo sucedido. Los investigadores revelaron que los ladrones vestían chalecos de alta visibilidad, haciéndose pasar por obreros. Llegaron con una plataforma elevadora, algo habitual en las calles parisinas, y la usaron para acceder a un balcón con vistas al Sena. Vestidos como trabajadores, parecían pertenecer al entorno.

La psicología de la percepción y la IA

Esta estrategia funcionó porque no vemos el mundo de forma objetiva, sino a través de categorías y expectativas. Los ladrones comprendieron las categorías sociales que percibimos como "normales" y las explotaron para evitar sospechas. Muchos sistemas de inteligencia artificial (IA) operan de manera similar y, como resultado, son vulnerables a los mismos tipos de errores. El sociólogo Erving Goffman describiría lo sucedido en el Louvre con su concepto de la presentación del yo: las personas "interpretan" roles sociales adoptando las señales que los demás esperan. En este caso, la representación de la normalidad se convirtió en el camuflaje perfecto. Los humanos realizamos categorizaciones mentales constantemente para dar sentido a personas y lugares. Cuando algo encaja en la categoría de "ordinario", pasa desapercibido. Esta capacidad de categorización es fundamental tanto para la percepción humana como para el funcionamiento de la IA.

Cómo la IA imita la percepción humana

Los sistemas de IA utilizados para tareas como el reconocimiento facial o la detección de actividades sospechosas en áreas públicas operan de forma parecida. Para los humanos, la categorización es cultural; para la IA, es matemática. Sin embargo, ambos sistemas se basan en patrones aprendidos en lugar de la realidad objetiva. Dado que la IA aprende de datos sobre quién parece "normal" y quién parece "sospechoso", absorbe las categorías incrustadas en sus datos de entrenamiento, lo que la hace susceptible a sesgos. Los ladrones del Louvre no fueron vistos como peligrosos porque encajaban en una categoría de confianza. En la IA, el mismo proceso puede tener el efecto contrario: las personas que no se ajustan a la norma estadística se vuelven más visibles y son objeto de un escrutinio excesivo. Esto puede llevar a que un sistema de reconocimiento facial señale desproporcionadamente a ciertos grupos raciales o de género como amenazas potenciales, mientras que otros pasan desapercibidos.

El espejo algorítmico de nuestras categorías

Una perspectiva sociológica nos ayuda a entender que estos no son problemas aislados. La IA no inventa sus categorías; aprende las nuestras. Cuando un sistema de visión por ordenador se entrena con imágenes de seguridad donde lo "normal" se define por cuerpos, vestimenta o comportamientos particulares, reproduce esas suposiciones. Al igual que los guardias del museo pasaron por alto a los ladrones porque parecían pertenecer al lugar, la IA puede pasar por alto ciertos patrones mientras reacciona de forma exagerada a otros. La categorización, ya sea humana o algorítmica, es un arma de doble filo. Nos ayuda a procesar información rápidamente, pero también codifica nuestras suposiciones culturales. Tanto las personas como las máquinas dependen del reconocimiento de patrones, una estrategia eficiente pero imperfecta. Una visión sociológica de la IA trata a los algoritmos como espejos que reflejan nuestras categorías y jerarquías sociales.

El caso del Louvre y la IA

En el caso del Louvre, el espejo se vuelve hacia nosotros. Los ladrones triunfaron no porque fueran invisibles, sino porque fueron vistos a través del prisma de la normalidad. En términos de IA, superaron la prueba de clasificación. Este vínculo entre percepción y categorización revela algo importante sobre nuestro mundo cada vez más algorítmico. Ya sea un guardia decidiendo quién parece sospechoso o una IA determinando quién parece un "ladrón de tiendas", el proceso subyacente es el mismo: asignar personas a categorías basándose en señales que parecen objetivas pero que son aprendidas culturalmente. Cuando un sistema de IA se describe como "sesgado", a menudo significa que refleja esas categorías sociales con demasiada fidelidad. El robo del Louvre nos recuerda que estas categorías no solo dan forma a nuestras actitudes, sino también a lo que se nota. Antes de enseñar a las máquinas a ver mejor, debemos aprender a cuestionar cómo vemos nosotros.

Lecciones del robo para el futuro de la seguridad

Tras el robo, el ministro de Cultura de Francia prometió nuevas cámaras y una seguridad más estricta. Sin embargo, por avanzados que sean estos sistemas, seguirán basándose en la categorización. Alguien, o algo, debe decidir qué constituye un "comportamiento sospechoso". Si esa decisión se basa en suposiciones, los mismos puntos ciegos persistirán. El robo del Louvre será recordado como uno de los atracos a museos más espectaculares de Europa. Los ladrones tuvieron éxito porque dominaron la sociología de la apariencia: entendieron las categorías de la normalidad y las usaron como herramientas. Al hacerlo, demostraron cómo tanto las personas como las máquinas pueden confundir la conformidad con la seguridad. Su éxito a plena luz del día no fue solo un triunfo de la planificación, sino un triunfo del pensamiento categórico, la misma lógica que subyace tanto a la percepción humana como a la inteligencia artificial. La lección es clara: antes de enseñar a las máquinas a ver mejor, debemos aprender a cuestionar cómo vemos nosotros.