- Una nueva tecnología de lente permite enfocar todos los objetos en una escena, sin importar su distancia.

- El sistema combina una lente Lohmann con un modulador de luz espacial para ajustar el enfoque por píxel.

- Esta innovación podría tener aplicaciones más allá de la fotografía, como en microscopía o realidad virtual.

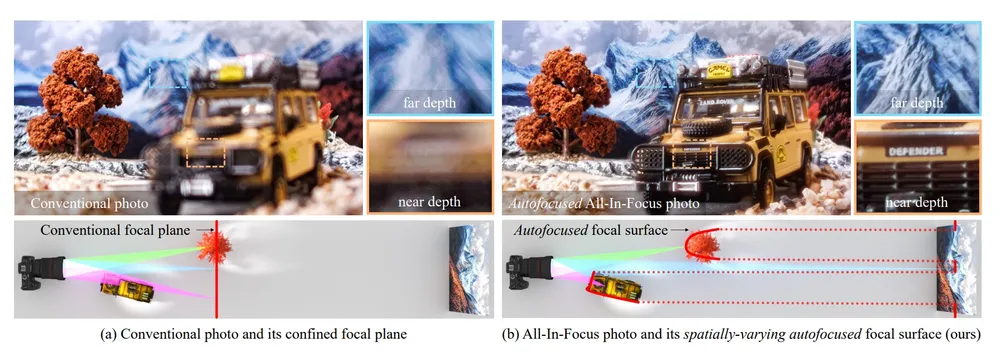

La fotografía tradicional, al igual que el ojo humano, se ha enfrentado históricamente a la limitación de enfocar un solo plano a la vez. Sin embargo, un avance en la tecnología de lentes desarrollado por investigadores de la Universidad Carnegie Mellon (CMU) promete cambiar esta realidad. Este nuevo sistema es capaz de enfocar cada parte de una escena con una nitidez excepcional, capturando detalles finos en toda la imagen, independientemente de la distancia de los objetos. Este desarrollo podría redefinir la forma en que las cámaras perciben el mundo.

Innovación en lentes: enfoque total simultáneo

Las lentes convencionales solo pueden enfocar un plano focal específico, dejando desenfocado todo lo que se encuentra delante o detrás. Si bien este efecto puede aportar profundidad a las imágenes, obtener una visión clara de todos los elementos suele requerir la combinación de múltiples fotografías tomadas con diferentes longitudes de enfoque. El nuevo sistema de “autofoco espacialmente variable” supera esta barrera al integrar tecnologías que permiten a la cámara seleccionar qué partes de la imagen deben ser nítidas. Cada píxel actúa de forma independiente, como si tuviera su propia lente diminuta y ajustable.

Tecnología de lente computacional

Los investigadores han creado una “lente computacional” que fusiona una lente Lohmann, compuesta por dos lentes cúbicas que se desplazan para ajustar el enfoque, con un modulador de luz espacial de fase. Este último controla la refracción de la luz en cada píxel, posibilitando el enfoque simultáneo en diferentes profundidades. El sistema emplea dos métodos de autofoco: el Detección de Contraste (CDAF), que divide las imágenes en regiones para maximizar la nitidez de forma independiente, y el Detección de Fase (PDAF), que determina si un objeto está enfocado y la dirección de ajuste necesaria. La combinación de estas técnicas ofrece un control sin precedentes sobre la profundidad de campo.

Aplicaciones futuras y potencial de la tecnología

El sistema experimental, aunque aún no disponible comercialmente, tiene el potencial de transformar radicalmente la fotografía. Los investigadores de CMU sugieren que esta tecnología podría tener aplicaciones mucho más amplias que la fotografía tradicional. Entre ellas se incluyen mejoras significativas en la eficiencia de los microscopios, la creación de una percepción de profundidad más realista para los cascos de realidad virtual, y la asistencia a vehículos autónomos para que perciban su entorno con una claridad sin precedentes. La versatilidad de este avance abre un abanico de posibilidades tecnológicas.

Impacto en realidad virtual y vehículos autónomos

La capacidad de capturar información de profundidad con alta precisión es crucial para aplicaciones inmersivas como la realidad virtual, donde una percepción espacial convincente es fundamental para la experiencia del usuario. De manera similar, para los vehículos autónomos, una visión clara y detallada de todos los objetos en su campo de visión, sin importar su distancia, es esencial para una navegación segura y eficiente. Esta tecnología podría ser un componente clave para la próxima generación de sistemas de visión artificial.