- Microsoft ha descubierto 'Whisper Leak', un ataque que expone temas de conversación en IA.

- La vulnerabilidad permite inferir el contenido de chats cifrados analizando el tamaño y tiempo de los paquetes de datos.

- Empresas como OpenAI ya han implementado mitigaciones para contrarrestar esta amenaza.

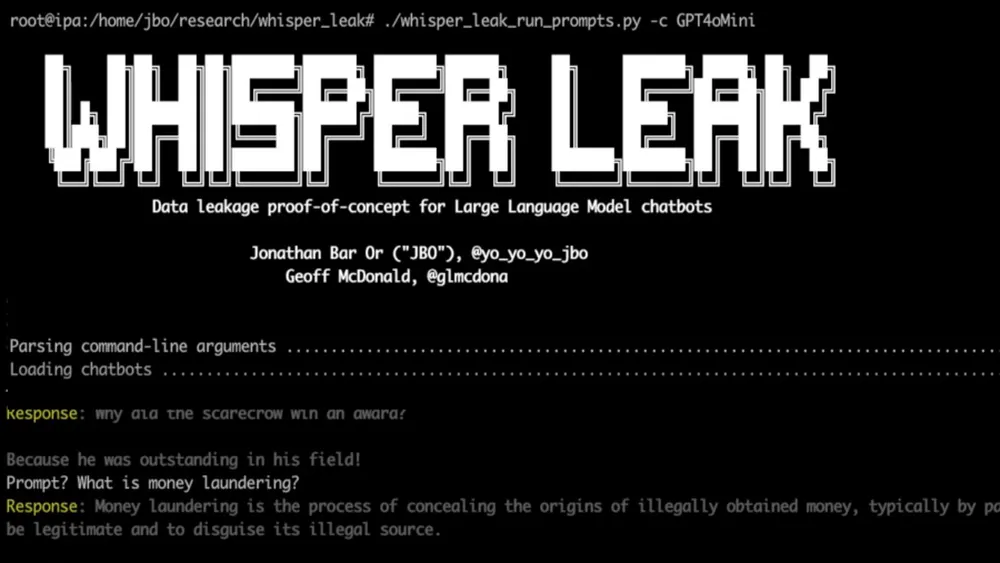

Microsoft ha alertado sobre un nuevo tipo de ciberataque denominado 'Whisper Leak', capaz de revelar los temas que los usuarios discuten con los chatbots de inteligencia artificial, incluso cuando las conversaciones están completamente cifradas. La investigación de la compañía sugiere que los atacantes pueden estudiar el tamaño y la temporización de los paquetes de datos cifrados intercambiados entre un usuario y un modelo de lenguaje grande (LLM) para inferir de qué se está hablando. Esto representa una seria amenaza para la privacidad de los usuarios.

El funcionamiento de 'Whisper Leak'

La vulnerabilidad reside en la forma en que los LLM envían sus respuestas. Estos modelos no esperan a tener una respuesta completa, sino que transmiten datos de forma incremental, creando pequeños patrones que los atacantes pueden analizar. Con el tiempo y la recolección de más muestras, estos patrones se vuelven más claros, permitiendo realizar conjeturas más precisas sobre la naturaleza de las conversaciones. Esta técnica no descifra los mensajes directamente, sino que expone suficientes metadatos para hacer inferencias, lo cual es igualmente preocupante.

Implicaciones para la seguridad

Microsoft señala que si una agencia gubernamental o un proveedor de servicios de internet estuvieran monitorizando el tráfico hacia un chatbot popular, podrían identificar de manera fiable a los usuarios que preguntan sobre temas sensibles específicos. Esto significa que el cifrado no garantiza la invisibilidad total de las conversaciones. La seguridad de los datos en las interacciones con IA sigue siendo un desafío importante.

Mitigaciones y recomendaciones ante la amenaza

Tras la divulgación de Microsoft, empresas como OpenAI, Mistral y xAI han actuado rápidamente para implementar mitigaciones. Una de las soluciones consiste en añadir una secuencia aleatoria de texto de longitud variable a cada respuesta, lo que interrumpe la consistencia de los tamaños de los tokens en los que los atacantes basan su análisis. Sin embargo, Microsoft recomienda a los usuarios evitar discusiones sensibles en redes Wi-Fi públicas, utilizar una VPN o optar por modelos de LLM que no utilicen streaming.

Vulnerabilidades persistentes en modelos de IA

Los hallazgos se producen junto con nuevas pruebas que demuestran que varios LLM de código abierto siguen siendo vulnerables a la manipulación, especialmente durante conversaciones de múltiples turnos. Investigadores de Cisco AI Defense han encontrado que incluso modelos desarrollados por grandes compañías tienen dificultades para mantener los controles de seguridad una vez que el diálogo se vuelve complejo. Algunos modelos muestran una incapacidad sistémica para mantener las barreras de seguridad a lo largo de interacciones prolongadas.